این مدل زبان بزرگ ترین و قدرتمند ترین مدل در تاریخ است که انتشار آن تحول عظیمی را در ابزارهای هوش مصنوعی مبتنی بر LLM مانند chatGPT ایجاد می کند. اکنون جستجوی بینگ نیز برای اولین بار از مدل GPT-4 در جستجوی خود استفاده می کند.

شرکت OpenAI، خالق ChatGPT، جدیدترین مدل هوش مصنوعی خود یعنی GPT-4 را عرضه کرد. این مدل قدرتمند قادر به درک تصاویر و متون است و از امروز از طریق سرویس پولی ChatGPT Plus در اختیار افراد قرار میگیرد، البته توسعهدهندگان باید برای دسترسی به API آن در لیست انتظار قرار بگیرند.

به گفته OpenAI، مدل GPT-4 از ورودیهای متنی و تصویر پشتیبانی میکند که پیشرفت خارق العاده ای نسبت به مدل GPT-3.5 محسوب میشود؛ مدلی که تنها از ورودیهای متنی پشتیبانی میکند. شرکت OpenAI به مدت 6 ماه بهطور مکرر از طریق برنامههای آزمایشی و همچنین ChatGPT، مشغول آزمایش این مدل بوده تا به بهترین نتایج دست پیدا کند.

طبق ادعای OpenAI، این مدل از همیشه خلاقتر است و میتواند مسائل دشوار را با دقت بالاتری حل کند. درحالحاضر OpenAI با چندین شرکت برای ادغام GPT-4 در محصولاتشان همکاری کرده است که شامل دولینگو و Stripe میشود.

اگرچه GPT-4 از ورودیهای متنی و تصویری پشتیبانی میکند، اما فعلا تنها با متن به کاربران جواب میدهد. منتهی این مدل زبان قادر است در قالب عکس و ویدئو بصورت طبیعی به شما پاسخ دهد. همانطور که گفتیم، این مدل از طریق سرویس ChatGPT پلاس با هزینه ماهانه 20 دلار در اختیار کاربران قرار میگیرد و طبق گفته مایکروسافت، این مدل برای چتبات بینگ مورد استفاده قرار گرفته است.

هرچند OpenAI می گوید در مکالمات معمولی تفاوت چندانی میان GPT-4 و GPT-3.5 وجود ندارد، سم آلتمن، مدیرعامل OpenAI در توییتی گفته که GPT-4 مسیر تکامل را طی می کند و همین حالا نیز تحت تاثیر قابلیت های آن قرار خواهید گرفت.

خالق GPT-4 میگوید بهبودهای این مدل در چندین آزمون و بنچمارک ازجمله LSAT و SAT Math مشهود است. در آزمونها GPT-4 توانسته نمرات بالایی کسب کند. GPT-4 درواقع یک مدل چند وجهی است که میتواند ورودیهای متن و تصویر را قبول کند، اما فعلا خروجیها بهصورت متن در اختیار کاربران قرار میگیرند.

به گفته OpenAI، این مدل میتواند بهطور همزمان متن و عکس را تجزیهوتحلیل کند تا قادر به تحلیل ورودیهای پیچیدهتر باشد. GPT-4 تحت آزمایشهای ایمنی نیز قرار داشته و به گفته سازندهاش، نسبت به مدل قبلی، GPT-3.5 تا 82 درصد کمتر به درخواستهای غیرمجاز پاسخ میدهد و همچنین 40 درصد احتمال بیشتری وجود دارد که پاسخهای واقعی بدهد.

کاربرد خارق العاده GPT-4

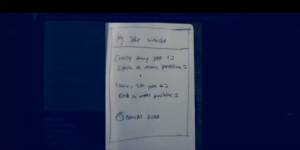

به گفته آقای Greg Brockman کوفاندر open-AI، مدل زبان GPT-4 یک مدل بصری نیز است و می تواند تصاویر را بصورت طبیعی درک کرده و با تصویر پاسخ دهد. این یعنی قدرت درک تصاویر بر اساس پاسخ های طبیعی مورد نیاز کاربر خواهد بود. به تصاویر پایین دقت کنید، در یک تصویر کانسپت یک وبسایت با خودکار کشیده شده و GPT4 آن را بصورت یک صفحه وب طراحی و کدهای آن را بصورت HTML و جاوا تحویل می دهد. طرح مورد نظرتان را روی کاغذ بکشید، صفحه وب تحویل بگیرید.

نویسنده علیرضا ناجی

سایر مقالات نویسنده