آیا میدانید فایل robots.txt چیست و چگونه میتوان با کمک آن سئوی سایت را بهبود داد؟ فایل robots.txt به موتورهای جستجو میگوید که چگونه وبسایت شما را مورد بررسی قرار دهند، همین امر سبب میشود فایل robots.txt به یک ابزار سئوی فوقالعاده قدرتمند تبدیل شود. برای افرادی که به سئوی سایت خود اهمیت داده و هیچ موردی را در این زمینه از قلم نمیاندازند، خواندن محتوای امروز که درباره ساخت فایل robots.txt برای وردپرس است، پیشنهاد میشود.

ساخت فایل robots.txt برای وردپرس

در قدم اول بهتر است فایل robots.txt را بطور کامل معرفی کنیم.

Robots.txt یک فایل متنی است که صاحبان وبسایت میتوانند آن را ایجاد کرده تا به رباتهای موتور جستجو نحوه خزیدن و ایندکس کردن صفحات در سایت خود را با کمک آن بگویند. معمولاً این فایل در پوشه اصلی وبسایت (مانند یا روت سایت یا Public_html ذخیره می شود و فرمت اصلی فایل robots.txt به شکل زیر است:

User-agent: [user-agent name] Disallow: [URL string not to be crawled] User-agent: [user-agent name] Allow: [URL string to be crawled] Sitemap: [URL of your XML Sitemap]

شما میتوانید چندین خط دستورالعمل برای مجاز یا غیرمجاز کردن URLهای خاص و اضافه کردن چندین نقشه سایت داشته باشید. اگر URL را مجاز نکنید، رباتهای موتور جستجو فرض میکنند که مجاز به خزیدن در آن هستند. در اینجا یک فایل نمونه robots.txt را مشاهده میکنیم:

User-Agent: * Allow: /wp-content/uploads/ Disallow: /wp-content/plugins/ Disallow: /wp-admin/ Sitemap:

در مثال بالا robots.txt، ما به موتورهای جستجو اجازه دادهایم تا فایلها را در پوشه آپلود وردپرس بررسی کرده و ایندکس کنند. پس از آن، رباتهای جستجو را از خزیدن و ایندکس کردن افزونههای وردپرس و پوشههای مدیریت وردپرس منع کردهایم. در نهایت، URL نقشه سایت XML خود را ارائه کردیم.

آیا وجود فایل Robots.txt در سایت ضروری است؟

اگر فایل robots.txt ندارید، موتورهای جستجو همچنان وبسایت شما را بررسی کرده و ایندکس میکنند. با این حال، نمیتوانید به آنها بگویید که کدام صفحات یا پوشهها را نباید خزش کنند. وقتی برای اولین بار وبلاگی را راه اندازی میکنید و محتوای زیادی ندارید، این مسئله تأثیر چندانی نخواهد داشت. با این حال، زمانیکه وبسایت شما رشد میکند و محتوای بیشتری اضافه میکنید، باید کنترل بهتری بر نحوه خزیدن و ایندکس شدن وبسایت خود داشته باشید. اینجاست که نیاز به ساخت فایل ربات در وردپرس دارید.

رباتهای جستجو دارای سهمیه خزیدن برای هر وبسایتی هستند. این بدان معنی است که رباتها تعداد مشخصی از صفحات را در طول یک جلسه خزش میکنند. اگر بررسی تمام صفحات سایت را به پایان نرسانند، در جلسه بعدی باز میگردند و خزیدن را از سر میگیرند. این موضوع میتواند نرخ ایندکس کردن وبسایت شما را کاهش دهد.

میتوانید این مشکل را با جلوگیری از تلاش رباتهای جستجو برای خزیدن در صفحات غیرضروری مانند صفحات مدیریت وردپرس، فایلهای افزونه و پوشه تمها برطرف کنید. با غیر مجاز کردن صفحات غیر ضروری، سهمیه خزیدن خود را ذخیره میکنید. این موضوع به موتورهای جستجو کمک میکند تا صفحات بیشتری را در سایت شما بررسی کرده و آنها را در سریعترین زمان ممکن ایندکس کنند.

یکی دیگر از دلایل مهم در ساخت فایل robots.txt برای وردپرس زمانی است که میخواهید موتورهای جستجو را از ایندکس کردن یک پست یا صفحه در وبسایت خود باز دارید. این کار امنترین راه برای پنهان کردن محتوا از عموم مردم نیست، اما به شما کمک میکند تا از نمایش محتوا در نتایج جستجو جلوگیری کنید.

یک فایل Robots.txt ایده آل چگونه است؟

بسیاری از وبلاگهای محبوب از یک فایل robots.txt بسیار ساده استفاده میکنند. محتوای آنها ممکن است بسته به نیازهای سایت خود متفاوت باشد. نمونه زیر را ببینید:

User-agent: * Disallow: Sitemap: Sitemap:

این فایل robots.txt به همه رباتها اجازه میدهد تا تمام محتوا را ایندکس کنند و پیوندی به نقشههای سایت XML وبسایت در اختیارشان قرار میدهد. برای سایتهای وردپرسی، قوانین زیر را در فایل robots.txt توصیه میکنیم:

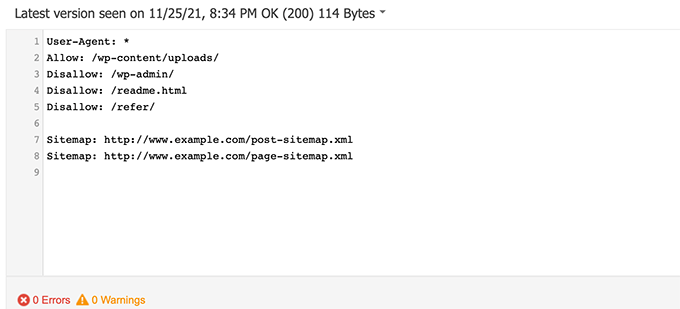

User-Agent: * Allow: /wp-content/uploads/ Disallow: /wp-admin/ Disallow: /readme.html Disallow: /refer/ Sitemap: Sitemap:

این دستور به رباتهای جستجو میگوید که تمام تصاویر و فایلهای وردپرس را ایندکس کنند. این رباتهای جستجو را از ایندکس ناحیه مدیریت وردپرس، فایل readme و پیوندهای وابسته پنهانشده منع میکند. با افزودن نقشه سایت به فایل robots.txt، یافتن تمام صفحات سایت خود را برای رباتهای گوگل آسان میکنید. اکنون که میدانید یک فایل robots.txt ایده آل چگونه است، بیایید نگاهی به نحوه ایجاد یک فایل robots.txt در وردپرس بیندازیم.

چگونه یک فایل robots.txt بسازیم؟

ما در اینجا دو راه برای ساخت فایل ربات در وردپرس درنظر گرفتیم. شما میتوانید روشی را انتخاب کنید که بهترین کارایی را برایتان دارد.

روش اول: ایجاد Robots.txt به کمک افزونه Yoast SEO

با فرض اینکه از افزونه یواست سئو استفاده میکنید، این روش را در نظر گرفتیم. سادهترین راه برای ایجاد یا ویرایش فایل robots.txt از طریق افزونه یواست در داشبورد وردپرس است. برای این کار مراحل زیر را دنبال کنید.

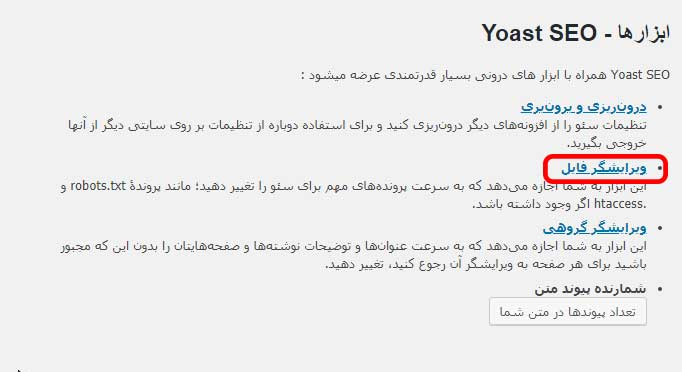

روی Yoast seo در پیشخوان وردپرس کلیک کنید و سپس روی گزینه ابزارها کلیک کنید:

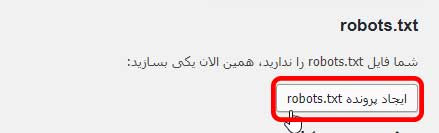

در اینجا گزینه ویرایشگر فایل را مشاهده میکنید. باید روی این گزینه کلیک کنید تا امکان ساخت فایل robots.txt برای وردپرس را به شما نشان دهد. حال روی دکمه ایجاد پرونده robots.txt کلیک کنید:

در اینجا امکان مشاهده (یا ویرایش) فایل تولید شده توسط افزونه یواست وجود دارد. دستورالعملهایی را که یواست سئو به صورت پیشفرض به فایل اضافه میکند، مشاهده خواهید کرد. همچنین میتوانید فایل را در اینجا ویرایش کنید.

روش دوم: ساخت و ویرایش دستی فایل Robots.txt با استفاده از FTP

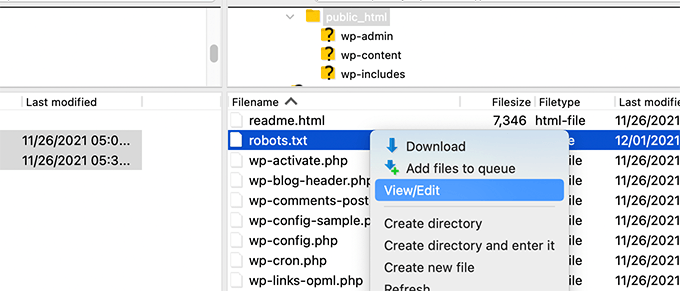

در این روش، باید از یک سرویس FTP برای ویرایش فایل robots.txt استفاده کنید. به سادگی با استفاده از یک سرویس FTP به فایلهای وبسایت وردپرس خود متصل میشوید. هنگامی که وارد شوید، میتوانید فایل robots.txt را در پوشه روت وبسایت خود مشاهده کنید.

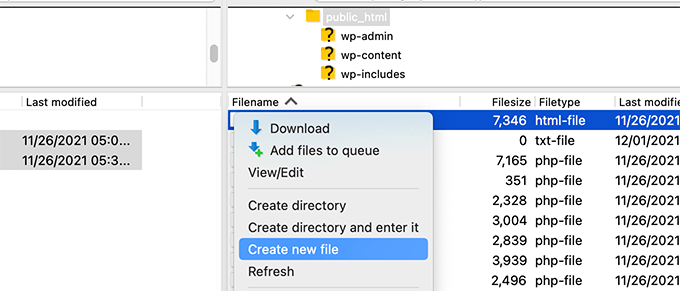

اگر چنین چیزی را نمیبینید، احتمالاً فایل robots.txt ندارید. در آن صورت، شما فقط باید یک فایل ایجاد کنید. مسیر زیر را طی کنید:

Robots.txt یک فایل متنی ساده است، به این معنی که میتوانید آن را در رایانه خود دانلود کرده و با استفاده از هر ویرایشگر متن ساده مانند Notepad یا TextEdit آن را ویرایش کنید. پس از ذخیره تغییرات خود، میتوانید فایل robots.txt خالی را به پوشه روت وب سایت انتقال داده و بارگذاری کنید.

چگونه فایل Robots.txt خود را تست کنیم؟

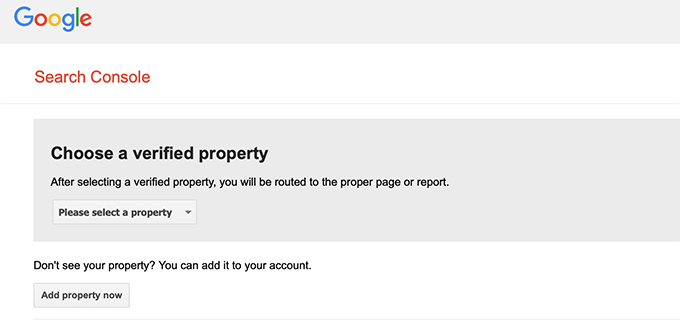

هنگامی که فایل robots.txt خود را ایجاد کردید، بهتر است آن را با استفاده از ابزار تست robots.txt آزمایش کنید. ابزارهای تست برای robots.txt زیادند، اما توصیه میکنیم از ابزاری که در داخل کنسول جستجوی گوگل قرار دارد استفاده کنید. برای این منظور لازم است که سایت شما در کنسول گوگل ثبت شده باشد. سپس، میتوانید از ابزار تست ربات کنسول جستجوی گوگل استفاده کنید.

به سادگی گزینه موردنظر خود را از لیست کشویی انتخاب کنید. این ابزار به طور خودکار فایل robots.txt وبسایت را دریافت کرده و در صورت یافتن خطاها و هشدارها آنها را نشان میدهد.

جمع بندی از ساخت فایل robots.txt برای وردپرس

هدف از بهینه سازی فایل robots.txt جلوگیری از خزیدن موتورهای جستجو در صفحاتی است که به صورت عمومی در دسترس نیستند. به عنوان مثال، صفحاتی در پوشه wp-plugins یا صفحاتی در پوشه مدیریت وردپرس شما وجود دارند که قرار نیست ایندکس شوند.

یک تصور رایج در بین متخصصان سئو این است که مسدود کردن دستهها، برچسبها و صفحات آرشیو وردپرس باعث بهبود نرخ خزیدن و در نتیجه ایندکس سریعتر و رتبهبندی بالاتر میشود. اما چنین تصوری درست نیست. تنها یک سری محتوای خاص هستند که واقعا نیازی به ایندکس شدن ندارند، از این رو ساخت فایل robots.txt برای وردپرس در این موارد توصیه میکنیم.

محصول پیشنهادی

قالب Edumall | قالب فروش دوره آموزش آنلاین اجومال

315,000 تومان

samadionline

محصول پیشنهادی

قالب آموزشی استادیار | قالب Studiare

577,500 تومان

وردپرسِ من!

محصول پیشنهادی

افزونه امتیازدهی و پاداش پیشرفته آوانس | پلاگین گیمیفیکیشن

585,000 تومان

یوسف محمدیانی

محصول پیشنهادی

قالب آموزشی و فروش دوره آنلاین آموزشیار | قالب Amoozeshyar

495,000 تومان

کارگاه وردپرس

محصول پیشنهادی

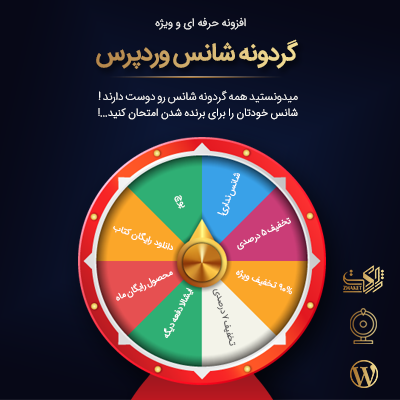

افزونه گردونه شانس اپتین | پلاگین WP Optin Wheel Pro

445,000 تومان

دیجیراتی

محصول پیشنهادی

افزودنی گردونه شانس اُپتین پلاس مهام | پلاگین MahamSoft WP Optin Wheel Pro Plus Addon

699,000 تومان

ایده پردازان مهام

محصول پیشنهادی

قالب آموزشی و فروش دوره آنلاین شکرینو | Shokrino

387,000 تومان

تیم شکرینو

نویسنده بهاره کوهستانی

سایر مقالات نویسنده